Технологія deep fake як привід для початку війни

новий світ з deep fake

інтернет зараз є чи не в кожному прасці, стає все складніше знайти точку на карті, де мережа 4g була б недоступна. Широкосмуговий інтернет – це перш за все відео в якості hd поширених на платформах, які поступово замінюють для нас новинні стрічки, аналітику та просто розважальне чтиво. Крім того, це інструмент впливу на мільярди людей, дозволяє створювати потрібну в даний момент громадську думку. На піку цих ігор з населенням може виявитися технологія deep fake, яка вже довела свою здатність перетворити знаменитостей, таких, як галь гадот, скарлетт йоханссон, тейлор свіфт, емма уотсон і кеті перрі, зірок порноіндустрії.Дипфейк – це алгоритм, що дозволяє моделювати поведінка і зовнішність людини на відеозаписі. Ім'я технологія отримала від поєднання deep learning («глибоке навчання») і fake («підробка»). В основі deep fake лежать горезвісні нейронні мережі, які працюють за генеративно-змагального принципу (generative adversarial network, gan). Алгоритми, закладені в базу програми, постійно змагаються один з одним у двох процесах: навчання на представлених фотографіях з метою створення реальної підміни особи на копії і виключення непридатних варіантів до тих пір, поки машина сама не почне плутати оригінал і копію.

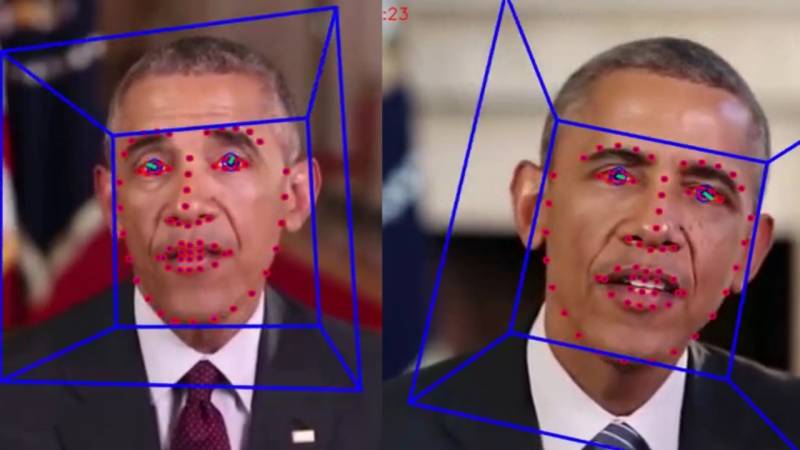

У цій складній схемі полягає основна мета роботи deep fake – створення помилкових фотографій і відеоконтенту, в яких особа оригіналу замінюється іншим чином. Приміром, харизматичний президент сша дональд трамп цілком може стати на місце будь-якого одіозного лідера xx століття і нести в маси з трибуни відверту єресь. Зараз же в одному з згенерованих deep fake відео колишній президент барак обама дозволив собі нецензурні вирази на адресу дональда трампа.

Деякі ці твори представлені на відео і, чесно кажучи, багато з них виглядають дещо незграбно.

У нього завдання ще більш небезпечна – «змусити» зображення людини свої голосом вимовляти будь-який текст на будь-якій мові. Для цього потрібно всього 40-хвилинне відео зі звуком, в ході якого нейронна мережа навчиться працювати з голосом і мімікою людини, трансформуючи це для нових словесних виразів. Спочатку ідея, звичайно, позиціонується як блага: основним споживачем neural rendering стануть кіностудії, бажають скоротити час на зйомку акторських дублів. Проте всім відразу стало зрозуміло, що в недалекому майбутньому фактично будь-який користувач може у себе на ноутбуці генерувати видеофейки, від яких волосся встане дибки.

Другим відгалуженням «фейкової» програми стало додаток deepnude, здатне досить реалістично «роздягнути» догола на фотографії будь-яку жінку. У перші дні роботи сервісу обсяг звалилися запитів був настільки великий, що розробники в побоюванні судових позовів оголосили про його закриття. Але хакери зламали ресурс, і зараз deepnude може скористатися кожен. Звичайно, сервіс намагаються обмежити в доступі, але всі розуміють, що це лише тимчасова міра. Deep fake виявився непоганим інструментом в руках шахраїв.

Одну британську енергетичну компанію пограбували на 220 тис. Євро, коли на зв'язок з фінансовим відділом вийшов «клон» керуючого з німеччини. Він змодельованим голосом попросив терміново перевести гроші на рахунок в угорщині, і в бізнес-партнерів не було ні єдиного приводу не вірити абоненту. Звичайно, зараз масово і якісно підробляти відеоряд проблематично – державні регулятори постійно блокують ресурси з fakeapp і facefake, та й потужності комп'ютерів поки не дозволяють оперативно синтезувати відео.

Доводиться передоручати цю роботу віддаленим платним серверів, яким для роботи вимагають тисячі фотографій оригінальної особистості і «жертви».

саѕиѕ belli

технологія deep fake може в майбутньому залишити акторів без роботи – вся індустрія цілком може перейти на «мультяшних» кіногероїв, багатьох з яких технологія воскресить з мертвих. Але цешвидше мрії про майбутнє, так як численні профспілки і елементарна нестача обчислювальних потужностей відсуває перспективу на кілька років вперед. Хоча вже зараз у фільмі «ізгой один: зоряні війни» режисер для одного епізоду «воскресив» актора пітер кушинга, який помер у 1994 році. Ходять чутки, що в новому фільмі про війну у в'єтнамі може з'явитися знаменитий джеймс дін.Нейромережі допомагають акторам, які вже в роках, виглядати в кадрі на 10-20 років молодше – приміром, арнольду шварценеггеру і джонні деппу. В середньому в світі зараз генерується не менше 15-20 тис. Deepfake відео кожен місяць, велика частина яких з'являється в інтернеті. Російські програмісти намагаються йти в руслі світових трендів — компанія vera voice в липні 2020 року запропонує шанувальникам творчості володимира висоцького поспілкуватися з цифровою копією співака в театрі на таганці. Все йде до того, що відео - і фотодокази перестануть бути дієвими аргументами в судових розглядах, а глобальна система відеоспостереження виявиться марною тратою грошей.

Ніхто не буде довіряти кадрів з камер відеоспостереження. Де гарантія, що це не синтезована пустушка? у політичній пропаганді deep fake вже зараз стає найпотужнішим важелем впливу на думку виборців. Каліфорнія в жовтні 2019 році стала першим штатом, взагалі заборонив викладати в мережу ролики з політичними кандидатами за 60 днів і менше до виборів. За порушення цього закону ав 730 загрожує кримінальна відповідальність.

Зараз до цієї ініціативи приєднали ще кілька штатів, а січня 2020 року в китаї буде заборонено публікувати синтезовані deep fake фото і відео без особливої позначки. До речі, зараз одним з дієвих прийомів визначення підробки на око є відсутність природного моргання у синтезованих персонажів.

Примітка (0)

Ця стаття не має коментарів, будьте першим!